Mit einem Webcrawler können Sie externe Inhalte crawlen und indizieren, damit sie für die Suche im Help Center und die generative Suche verwendet werden können. Auf diese Weise lässt sich die Verbundsuche im Help Center ganz ohne Entwicklerressourcen implementieren. Sie können mehrere Crawler einrichten, um verschiedene Inhalte in einer oder mehreren Websites zu indizieren.

Wenn Benutzer in Ihrem Help Center eine Suche durchführen, werden externe Inhalte, die der Crawler gefunden hat, entsprechend ihrer Relevanz auf der Seite mit den Suchergebnissen angezeigt. Benutzer können die Ergebnisse filtern und auf die Links klicken, um die externen Inhalte in einer neuen Browser-Registerkarte anzuzeigen.

Überblick über Webcrawler

Sie können einen oder mehrere Webcrawler einrichten, um externe Inhalte in einer oder mehreren Websites zu indizieren, die Sie für die Suche im Help Center und die generative Suche bereitstellen möchten. Externe Websites, auf die der Crawler zugreifen soll, müssen eine Sitemap aufweisen, in der die Seiten für den Webcrawler aufgelistet sind. Seiten, auf die der Crawler zugreifen soll, müssen außerdem öffentlich sein (nicht authentifiziert).

Konfigurierte Crawler werden alle 30 Minuten ausgeführt, besuchen die Seiten, die in der bei der Einrichtung angegebenen Sitemap aufgeführt sind, und übernehmen deren Inhalte in die Indizes für die Help-Center-Suche. Webcrawler indizieren alle beim erstmaligen Laden im Seitenquelltext enthaltenen Informationen, auch wenn diese durch ein UI-Element, etwa ein Akkordeon, verborgen sind. Da Crawler allerdings kein JavaScript ausführen, indizieren sie keine Inhalte, die mittels JavaScript oder dynamisch nach dem ersten Laden der Seite dargestellt werden.

Außerdem indizieren Webcrawler keine Links auf den von ihnen besuchten Seiten, sondern beschränken sich ausschließlich auf die Seiten in der Sitemap, für die sie eingerichtet wurden. Wenn der Crawler bei einem regelmäßigen Crawl keine Informationen von einer Website sammeln kann (z. B. wenn die Website nicht erreichbar ist oder Netzwerkprobleme vorliegen), bleiben im Help Center die Ergebnisse des vorherigen Crawls verfügbar und können weiterhin durchsucht werden.

Einrichten eines Webcrawlers

Mit einem Webcrawler können Sie die Verbundsuche im Help Center ganz ohne Entwicklerressourcen implementieren. Sie können im Help Center mehrere Crawler einrichten, um verschiedene Inhalte einer oder mehrerer Websites zu indizieren.

- Der Webcrawler funktioniert nicht mit Websites, die die Komprimierungscodierung gzip verwenden. Von diesen Websites werden keine Suchergebnisse angezeigt.

- Eine Crawl-Verzögerung („crawl-delay“) wird vom Webcrawler nicht beachtet, wenn sie in robots.txt-Einträgen für externe Websites festgelegt ist.

- Das Tag „changefreq” hat keinerlei Auswirkungen auf den Webcrawler.

So richten Sie einen Webcrawler ein

-

Klicken Sie in der Seitenleiste von Wissensadministrator auf Einstellungen (

).

).

- Klicken Sie auf Sucheinstellungen.

- Klicken Sie unter Crawler auf Verwalten.

- Klicken Sie auf Crawler hinzufügen.

- Geben Sie im Abschnitt Diesen Crawler benennen Folgendes ein:

- Name – Geben Sie den gewünschten Namen für den Crawler ein. Unter diesem internen Namen wird der Webcrawler in der Crawler-Verwaltungsliste angezeigt.

-

Inhaber – Geben Sie den Namen des Wissensadministrators ein, der für die Verwaltung des Crawlers und die Fehlerbehebung zuständig ist. Standardmäßig ist der Inhaber der Benutzer, der den Crawler erstellt hat. Sie können jedoch den Namen eines beliebigen anderen Wissensadministrators eingeben.

Der Inhaber des Crawlers wird per E-Mail benachrichtigt, wenn der Crawler erfolgreich ausgeführt wird, aber auch wenn beispielsweise bei der Domänenverifizierung, beim Verarbeiten der Sitemap oder beim Crawlen von Seiten Fehler auftreten.

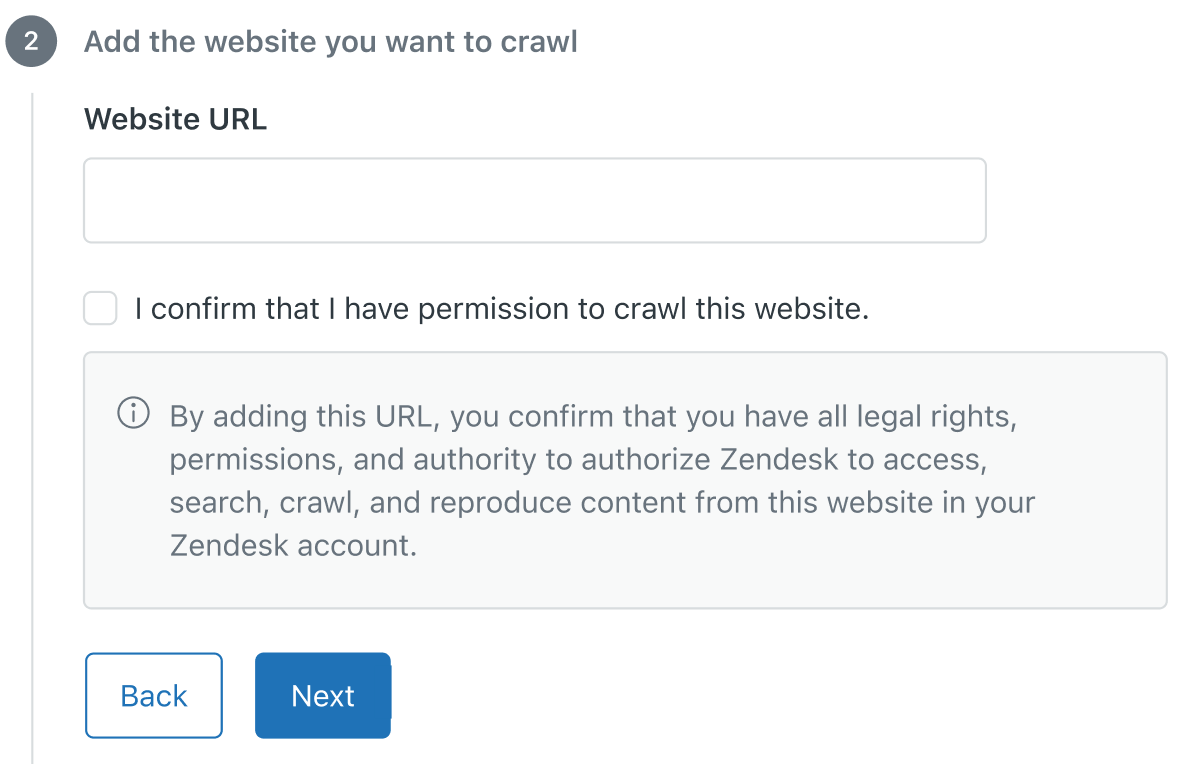

- Konfigurieren Sie unter Fügen Sie die Website hinzu, die Sie crawlen möchten die folgenden Einstellungen:

- Website-URL – Geben Sie die URL der Website ein, die Sie crawlen möchten.

- Ich bestätige, dass ich berechtigt bin, diese Website zu crawlen – Lesen Sie die Informationen unter diesem Kontrollkästchen und markieren Sie es dann, um zu bestätigen, dass Sie die Berechtigung zum Crawlen dieser Website haben.

- Geben Sie unter Sitemap hinzufügen im Feld Sitemap-URL die URL der Sitemap an, die der Crawler für Ihre Website verwenden soll.

Die Sitemap muss dem XML-Protokoll für Sitemaps entsprechen und eine Liste aller Seiten der Website enthalten, die Sie crawlen möchten. Bei der Sitemap kann es sich um die Standard-Sitemap handeln, in der sämtliche Seiten der Website aufgeführt sind, oder um eine spezielle Sitemap, die nur bestimmte Seiten enthält, auf die der Crawler zugreifen soll. Alle Sitemaps müssen in der Domäne gehostet werden, für die der Crawler konfiguriert ist. Der Webcrawler unterstützt keine Sitemap-Indizes.

Sie können für eine Website auch mehrere Crawler einrichten, die jeweils unterschiedliche Sitemaps mit den zu indizierenden Seiten verwenden.

- Konfigurieren Sie unter Filter hinzufügen, damit Benutzer diese Inhalte leichter finden können die Quell- und Typfilter, mit denen die Endbenutzer Suchergebnisse filtern können. Die Quelle gibt den Ursprung des externen Inhalts an, z. B. ein Forum, einen Issue Tracker oder ein Lernmanagementsystem. Der Typ gibt die Art des Inhalts an, z B. Blog-Post, Tech Note oder Fehlerbericht.

- Quelle – Klicken Sie auf den Pfeil und wählen Sie in der Liste eine Quelle aus oder klicken Sie auf + Neue Quelle erstellen und geben Sie einen Namen ein, der den Ursprung des betreffenden Inhalts beschreibt.

- Typ – Klicken Sie auf den Pfeil und wählen Sie in der Liste einen Typ aus, oder klicken Sie auf + Neuen Typ erstellen und geben Sie einen Namen ein, der die Art des betreffenden Inhalts beschreibt.

- Klicken Sie auf Fertigstellen. Der Webcrawler wird erstellt und wartet auf die Verifizierung. Innerhalb von 24 Stunden prüft der Crawler die Inhaberschaft der Domäne und ruft anschließend die Sitemap ab, um sie zu analysieren. Nach erfolgreicher Verarbeitung der Sitemap beginnt der Crawler, die Seiten zu crawlen und ihren Inhalt zu indizieren. Wenn die Domänenverifizierung oder die Verarbeitung der Sitemap fehlschlägt, erhält der Inhaber des Crawlers eine E-Mail-Benachrichtigung mit Tipps zur Behebung des Problems. Nach Ablauf von 24 Stunden startet der Crawler dann einen neuen Versuch.Hinweis: Der User Agent für den Webcrawler ist „Zendesk/External-Content“. Um zu verhindern, dass der Crawler durch eine Blockierungsanfrage der Firewall behindert wird, tragen Sie Zendesk/External-Content in Ihre Zulassungsliste ein.

- Help-Center-Suche: Sie müssen die Inhalte auswählen, die in den Suchergebnisse berücksichtigt bzw. außer Acht gelassen werden sollen. Weitere Informationen finden Sie unter Berücksichtigen externer Inhalte in den Help-Center-Suchergebnissen.

- Abschnitt „Wissen“ im Kontextfenster für Agenten: Befolgen Sie die Anweisungen unter Konfigurieren des Abschnitts „Wissen“ im Kontextfenster.