Le crawler Web vous permet d’explorer et d’indexer le contenu externe pour qu’il puisse être utilisé dans la recherche du centre d’aide et la recherche générative. Le crawler Web vous permet d’implémenter la recherche fédérée sans avoir à recourir aux ressources pour les développeurs. Vous pouvez configurer plusieurs crawlers pour explorer et indexer différents contenus dans un ou plusieurs sites Web.

Quand un utilisateur effectue une recherche dans votre centre d’aide, le content externe pertinent découvert par le crawler est classé et présenté à la page des résultats de recherche. Là, l’utilisateur peut filtrer les résultats et cliquer sur les liens pour consulter le lien du contenu externe dans un autre onglet de navigateur.

À propos du crawler Web

Vous pouvez configurer un ou plusieurs crawlers Web pour explorer et indexer le contenu externe d’un ou plusieurs sites Web que vous voulez mettre à la disposition de la recherche du centre d’aide et de la recherche générative. Les sites externes que vous voulez explorer doivent avoir un plan du site qui répertorie les pages pour le crawler Web. En outre, les pages que vous voulez explorer doivent être publiques (non authentifiées).

Une fois configurés, les crawlers sont programmés pour s’exécuter toutes les 30 minutes : ils visitent les pages du plan du site que vous avez spécifiées pendant la configuration et ingèrent le contenu de ces sources dans les index de recherche du centre d’aide. Les crawlers Web indexent le contenu qui se trouve dans la page source au chargement initial de la page, même s’il est masqué par un élément de l’interface, comme un accordéon. Cependant, puisque les crawlers n’exécutent pas JavaScript, ils n’explorent pas le contenu rendu par JavaScript ou tout autre contenu rendu dynamiquement après le chargement initial de la page.

En outre, les crawlers Web n’explorent pas les liens qui se trouvent sur les pages qu’ils visitent, ils visitent uniquement les pages du plan du site qu’ils sont configurés pour utiliser. Si le crawler n’arrive pas à recueillir d’information à partir d’un site Web pendant une exploration planifiée (si le site Web est indisponible ou s’il y a des problèmes de réseau, par exemple), le centre d’aide conserve les résultats de l’exploration précédente, dans lesquels il sera toujours possible d’effectuer des recherches dans le centre d’aide.

Configuration d’un crawler Web

Le crawler Web vous permet d’implémenter la recherche fédérée dans votre centre d’aide sans avoir à recourir aux ressources pour les développeurs. Vous pouvez configurer plusieurs crawlers dans votre centre d’aide pour explorer et indexer différents contenus dans un ou plusieurs sites Web.

- Le crawler Web ne fonctionne pas avec les sites Web qui utilisent le code de compression de fichiers gzip. Vous ne verrez pas de résultats de recherche provenant de ces sites.

- Le crawler Web ne respectera pas de délai de recherche (crawl-delay) s’il est défini pour les enregistrements robots.txt d’un site externe.

- Le marqueur changefreq n’affecte aucunement le crawler Web.

Pour configurer le crawler Web

-

Dans Administrateur de Connaissances, cliquez sur Paramètres (

) dans la barre latérale.

) dans la barre latérale.

- Cliquez sur Paramètres de recherche.

- Sous Crawlers, cliquez sur Gérer.

- Cliquez sur Ajouter un crawler.

- Dans Nommez ce crawler, saisissez les éléments suivants :

- Le nom que vous souhaitez affecter au crawler. Il s’agit d’un nom interne qui identifie le crawler Web dans la liste de gestion des crawlers.

-

Le propriétaire qui est l’administrateur Connaissances responsable de la maintenance et du dépannage du crawler. Par défaut, le propriétaire du crawler est l’utilisateur qui le crée. Cependant, vous pouvez le remplacer par n’importe quel administrateur Connaissances.

Le propriétaire d’un crawler reçoit une notification par e-mail quand l’exécution du crawler réussit et en cas d’erreurs, comme des problèmes avec la vérification du domaine, le traitement du plan du site ou l’exploration des pages.

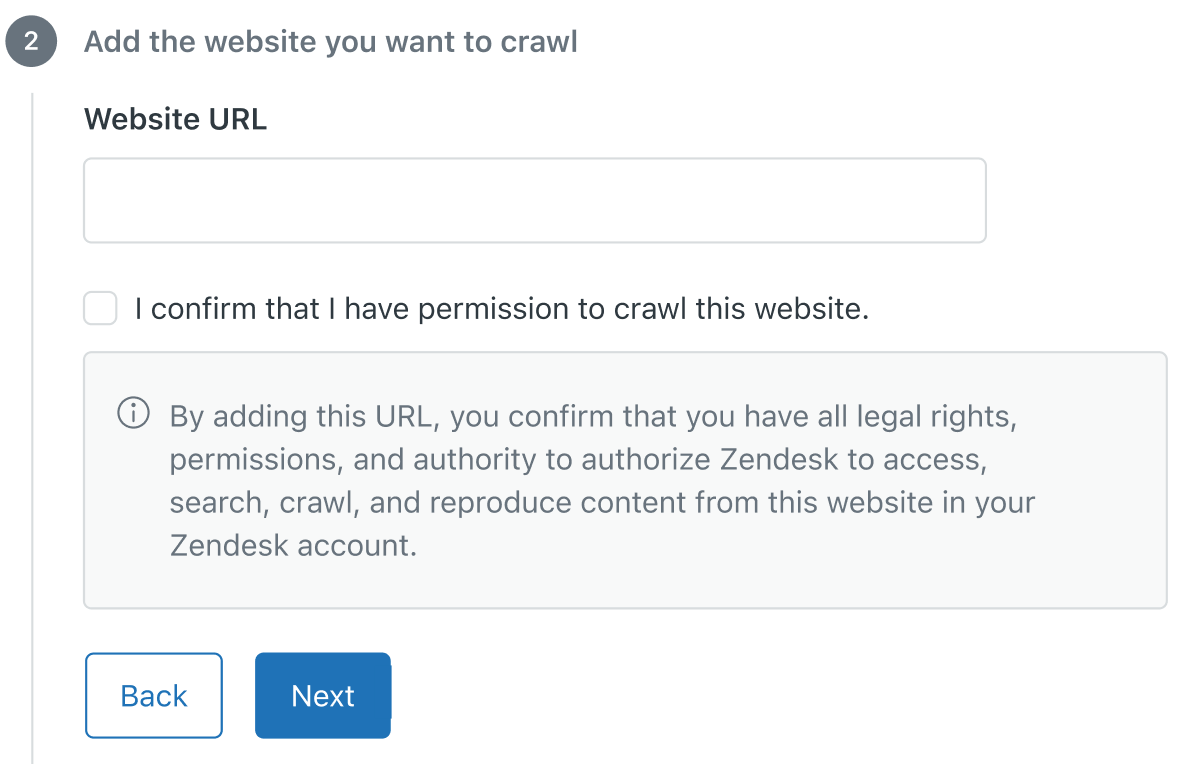

- Dans Ajoutez le site Web que vous voulez explorer, configurez les options suivantes :

- URL du site Web - Saisissez l’URL du site Web que vous voulez explorer.

- Je confirme que j’ai la permission d’explorer ce site Web - Lisez les informations affichées sous cette case à cocher, puis sélectionnez-la pour confirmer que vous avez la permission d’explorer ce site Web.

- Dans Ajoutez un plan du site, sous URL du plan du site, saisissez l’URL pour le plan du site que vous voulez que le crawler utilise quand il explore votre site.

Les plans du site doivent suivre le protocole XML des plans de site et contenir une liste de toutes les pages du site pour l’explorer. Le plan du site peut être le plan du site standard contenant toutes les pages du site ou un plan du site dédié répertoriant les pages que voulez explorer. Tous les plans du site doivent être hébergés dans le domaine que le crawler est configuré pour explorer. Le crawler Web ne prend pas les index de plans de site en charge.

Vous pouvez configurer plusieurs crawlers sur le même site, chacun utilisant un plan du site différent définissant les pages que le crawler Web doit explorer.

- Dans Ajoutez des filtres pour aider les utilisateurs à trouver ce contenu, configurez les filtres de source et de type utilisés pour filtrer les résultats de recherche par vos utilisateurs finaux. Les sources sont l’origine du contenu externe, comme les forums, les systèmes de suivi des problèmes ou les systèmes de gestion de l’apprentissage. Le type est le type de contenu, comme les articles de bloc, les notes techniques ou les rapports de bugs.

- Source - Cliquez sur la flèche et sélectionnez une source dans la liste ou sélectionnez + Créer une source pour ajouter un nom décrivant d’où provient ce contenu.

- Type - Cliquez sur la flèche et sélectionnez un type dans la liste ou sélectionnez + Créer un type pour ajouter un nom décrivant de quel genre de contenu il s’agit.

- Cliquez sur Terminer. Le crawler Web est créé et en attente. Dans un délai de 24 heures, le crawler vérifiera le propriétaire du domaine, puis récupérera et analysera le plan du site spécifié. Une fois le traitement du plan du site réussi, le crawler commence à explorer les pages et à indexer leur contenu. Si le crawler échoue pendant la vérification du domaine ou du traitement du plan du site, le propriétaire du crawler recevra une notification par e-mail avec des conseils de dépannage pour l’aider à résoudre le problème. Le crawler réessaiera 24 heures plus tard.Remarque – Zendesk/External-Content est l’agent utilisateur pour le crawler Web. Pour éviter qu’un crawler n’échoue à cause d’un pare-feu bloquant les demandes, ajoutez Zendesk/External-Content à votre liste autorisée.

- La recherche du centre d’aide : vous devez sélectionner le contenu à inclure et à exclure des résultats de recherche de votre centre d’aide. Consultez Inclusion du contenu externe dans les résultats de recherche de votre centre d’aide.

- La section Connaissances du volet contextuel pour les agents : consultez Configuration de la section Connaissances.